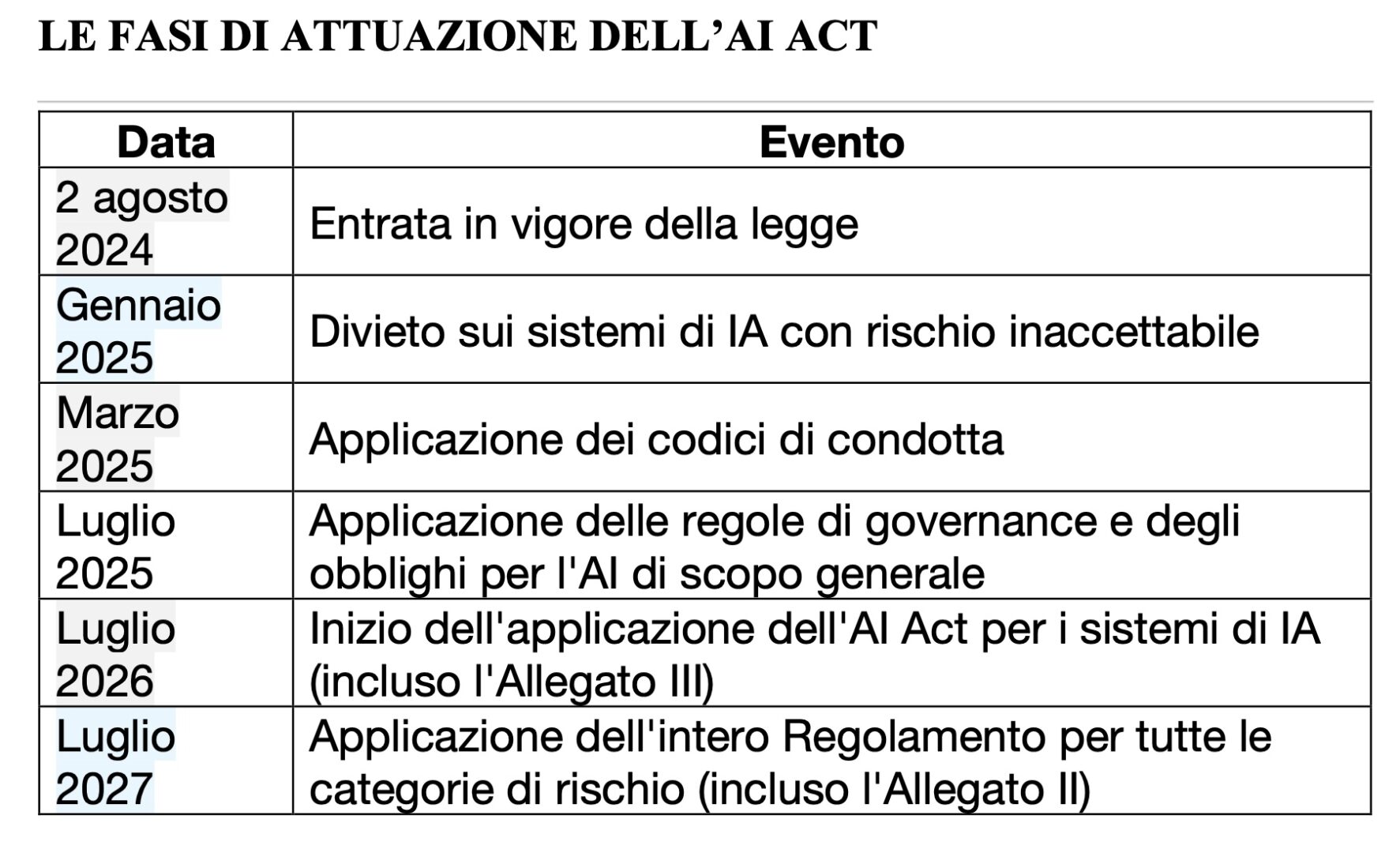

Venerdì 2 agosto entra in vigore l’AI Act, il primo regolamento al mondo sull’intelligenza artificiale approvato dal Parlamento Europeo in marzo e pubblicato sulla Gazzetta Ufficiale il 12 luglio. È prevista un’applicazione graduale, con diverse scadenze, fino alla piena operatività a partire dall’agosto 2026.

C’è, quindi, tempo per adeguarsi alle nuove regole ma bisogna cominciare a prepararsi. Professionisti, consulenti e manager hanno già cominciato a studiare le 419 pagine del testo dell’AI Act, che riguarderà a diversi livelli tutte le imprese (qui puoi leggere il testo completo dell’AI Act in italiano)

Adeguarsi all’AI Act richiede un approccio sistematico e integrato che copra vari aspetti della gestione dei sistemi di IA. L’azienda deve implementare un sistema di gestione della qualità, gestire i rischi, effettuare valutazioni d’impatto sui diritti fondamentali, garantire la sorveglianza umana, promuovere la trasparenza, adottare codici di buone pratiche, monitorare e aggiornare continuamente i sistemi, adottare misure correttive quando necessario e proteggere i dati personali. La partecipazione agli spazi di sperimentazione normativa può inoltre facilitare l’adeguamento e promuovere l’innovazione.

Visto che si parla di intelligenza artificiale, abbiamo chiesto a Lexroom AI Act, una piattaforma a base di algoritmi di generative AI verticale sulla norma, di aiutarci a trovare le risposte alle principali domande che circolano dentro le aziende. Ecco le risposte.

Indice degli argomenti

Come deve organizzarsi un’azienda per adeguarsi all’AI Act e alla sua progressiva attuazione? Quali misure adottare?

L’AI Act, approvato dal Parlamento Europeo, stabilisce un quadro normativo dettagliato per l’uso e lo sviluppo di sistemi di intelligenza artificiale nell’Unione Europea. Per un’azienda che desidera adeguarsi a questo regolamento, è essenziale comprendere e implementare una serie di misure e procedure specifiche. Di seguito, vengono delineati i principali aspetti a cui prestare attenzione e le misure da adottare.

1. Classificazione dei Sistemi di IA

L’azienda deve innanzitutto determinare se i suoi sistemi di IA rientrano nella categoria di “alto rischio” o meno. I sistemi di IA ad alto rischio sono soggetti a requisiti più stringenti rispetto a quelli non ad alto rischio [AI ACT / Articolo 1][AI ACT / Premessa 64].

2. Sistema di Gestione della Qualità

Per i sistemi di IA ad alto rischio, l’azienda deve istituire un sistema di gestione della qualità che garantisca la conformità al regolamento. Questo sistema deve essere documentato in modo sistematico e ordinato e deve includere politiche, procedure e istruzioni scritte che coprano vari aspetti come la progettazione, lo sviluppo, il controllo della qualità, la gestione dei dati e la gestione dei rischi [AI ACT / Articolo 17].

3. Gestione dei Rischi

L’azienda deve implementare un sistema di gestione dei rischi per identificare, valutare e gestire i rischi connessi all’uso dei sistemi di IA ad alto rischio. Questo processo deve essere iterativo e continuo, coprendo l’intero ciclo di vita del sistema di IA. Le misure di gestione dei rischi devono considerare le conoscenze tecniche, l’esperienza, l’istruzione e la formazione del deployer, nonché il contesto di utilizzo del sistema [AI ACT / Articolo 9].

4. Valutazione d’Impatto sui Diritti Fondamentali

Prima di utilizzare un sistema di IA ad alto rischio, l’azienda deve effettuare una valutazione dell’impatto sui diritti fondamentali. Questa valutazione deve includere una descrizione dei processi, del periodo di utilizzo, delle categorie di persone interessate, dei rischi specifici e delle misure da adottare in caso di rischi concretizzati. I risultati della valutazione devono essere notificati all’autorità di vigilanza del mercato e aggiornati se necessario [AI ACT / Articolo 27][AI ACT / Premessa 96].

5. Sorveglianza Umana

I sistemi di IA ad alto rischio devono essere progettati e sviluppati in modo tale da poter essere efficacemente supervisionati da persone fisiche durante il periodo in cui sono in uso. Le persone fisiche incaricate della sorveglianza devono avere le competenze, la formazione e l’autorità necessarie per svolgere tale ruolo. Devono essere in grado di comprendere le capacità e i limiti del sistema, monitorarne il funzionamento, interpretare correttamente l’output e intervenire se necessario [AI ACT / Articolo 14][AI ACT / Premessa 73].

6. Trasparenza e Informazione

L’azienda deve garantire che i sistemi di IA destinati a interagire direttamente con le persone fisiche siano progettati in modo tale che le persone siano informate del fatto di stare interagendo con un sistema di IA. Inoltre, gli output generati artificialmente devono essere marcati come tali. Le informazioni devono essere fornite in maniera chiara e accessibile alle persone interessate [AI ACT / Articolo 50][AI ACT / Premessa 132].

7. Codici di Buone Pratiche

L’azienda dovrebbe partecipare all’elaborazione e all’adozione di codici di buone pratiche, che possono aiutare a garantire la conformità al regolamento. Questi codici dovrebbero definire chiaramente gli obiettivi specifici e contenere impegni o misure per assicurare il conseguimento di tali obiettivi [AI ACT / Articolo 56][AI ACT / Premessa 116].

8. Monitoraggio e Aggiornamento

L’azienda deve monitorare continuamente il funzionamento dei sistemi di IA ad alto rischio e informare i fornitori in caso di problemi. Deve inoltre conservare i log generati automaticamente dai sistemi di IA per un periodo adeguato e cooperare con le autorità competenti per l’attuazione del regolamento [AI ACT / Articolo 26].

9. Misure Correttive

Se un sistema di IA ad alto rischio rappresenta un pericolo per la salute, la sicurezza delle persone o i diritti fondamentali, l’azienda deve adottare misure correttive nei confronti di tutti i sistemi di IA interessati. Queste misure devono essere adottate entro il termine prescritto dall’autorità di vigilanza del mercato [AI ACT / Articolo 82][AI ACT / Articolo 79].

10. Protezione dei Dati Personali

L’azienda deve garantire che il trattamento dei dati personali sia conforme ai regolamenti UE sulla protezione dei dati personali, come il GDPR. Questo include la gestione dei dati utilizzati per l’addestramento, la convalida e la prova dei sistemi di IA, nonché la protezione della riservatezza delle informazioni [AI ACT / Premessa 10][AI ACT / Articolo 78][AI ACT / Articolo 10].

11. Spazi di Sperimentazione Normativa

L’azienda può partecipare agli spazi di sperimentazione normativa per l’IA, che offrono un ambiente controllato per la sperimentazione e la prova dei sistemi di IA innovativi. Questi spazi aiutano a garantire la conformità ai regolamenti vigenti e a promuovere l’innovazione [AI ACT / Premessa 139][AI ACT / Premessa 138].

Quali sono le prime norme dell’AI Act che entreranno in vigore anche in Italia dal 2 agosto 2024?

Il Regolamento sull’Intelligenza Artificiale dell’Unione Europea stabilisce una serie di norme e tempistiche per la loro entrata in vigore. In base alle fonti disponibili, le prime norme che entreranno in vigore anche in Italia a partire dal 2 agosto 2024 sono le seguenti:

1. **Divieti e Disposizioni Generali**:

– A causa dei rischi inaccettabili associati all’uso dell’IA in determinati contesti, i divieti e le disposizioni generali del regolamento dovrebbero applicarsi già a partire da sei mesi dalla data di entrata in vigore del regolamento, ovvero dal 2 agosto 2024 [AI ACT / Premessa 179]. Queste disposizioni includono il divieto di pratiche di IA che presentano rischi inaccettabili per la sicurezza, i diritti fondamentali e i valori dell’Unione Europea.

2. **Capi I e II**:

– I capi I e II del regolamento si applicano a decorrere dal 2 agosto 2024 [AI ACT / Articolo 113]. Questi capitoli riguardano le disposizioni generali e le definizioni, nonché le norme sull’ambito di applicazione del regolamento.

3. **Obblighi per i Fornitori di Modelli di IA per Finalità Generali**:

– Gli obblighi per i fornitori di modelli di IA per finalità generali dovrebbero applicarsi a partire da 12 mesi dalla data di entrata in vigore del regolamento, ma le disposizioni generali e i divieti specifici per i rischi inaccettabili anticipano questa scadenza, rendendo alcune norme applicabili già dal 2 agosto 2024 [AI ACT / Premessa 179].

4. **Codici di Buone Pratiche**:

– I codici di buone pratiche dovrebbero essere pronti entro nove mesi dalla data di entrata in vigore del regolamento, ma è importante che i fornitori inizino a dimostrare la conformità in tempo utile. Pertanto, anche se non obbligatoriamente in vigore dal 2 agosto 2024, i fornitori dovrebbero già iniziare a prepararsi per l’adozione di tali codici [AI ACT / Premessa 179].

5. **Norme Relative alla Conformità dei Sistemi di IA ad Alto Rischio**:

– I sistemi di IA ad alto rischio o i modelli di IA per finalità generali che sono conformi alle norme armonizzate dell’Unione Europea si presumono conformi ai requisiti del regolamento. La Commissione Europea presenta richieste di normazione senza indebito ritardo per garantire che tali sistemi soddisfino i requisiti del regolamento [AI ACT / Articolo 40]. Anche se la piena applicazione di queste norme potrebbe richiedere più tempo, le disposizioni generali e i divieti specifici per i rischi inaccettabili anticipano alcune di queste norme.

In sintesi, le prime norme dell’AI Act che entreranno in vigore in Italia dal 2 agosto 2024 includono i divieti e le disposizioni generali per mitigare i rischi inaccettabili, le disposizioni dei capi I e II, e gli obblighi preliminari per i fornitori di modelli di IA per finalità generali. Queste norme sono state antic

Che cosa dovranno fare le aziende che usano sistemi di intelligenza artificiale dal 2 agosto 2024?

Con l’entrata in vigore dell’AI ACT il 2 agosto 2024, le aziende che utilizzano sistemi di intelligenza artificiale (IA) dovranno conformarsi a una serie di obblighi e requisiti specifici delineati nel regolamento.

Questi obblighi variano a seconda del tipo di sistema di IA utilizzato e del contesto in cui viene impiegato. Di seguito, una panoramica dettagliata delle principali disposizioni che le aziende dovranno rispettare:

1. Obblighi di Trasparenza e Informazione

Le aziende dovranno garantire che le persone fisiche siano informate quando interagiscono con un sistema di IA, a meno che ciò non sia evidente per una persona ragionevolmente informata, attenta e avveduta, tenendo conto delle circostanze e del contesto di utilizzo [AI ACT / Articolo 50][AI ACT / Premessa 132]. Inoltre, i fornitori di sistemi di IA che generano contenuti sintetici (audio, immagini, video o testi) dovranno assicurarsi che tali contenuti siano marcati in modo leggibile e rilevabili come generati o manipolati artificialmente [AI ACT / Articolo 50].

2. Deep Fake

I deployer che utilizzano sistemi di IA per generare o manipolare contenuti che assomigliano notevolmente a persone, oggetti, luoghi, entità o eventi esistenti e che potrebbero apparire falsamente autentici (deep fake), dovranno rendere noto in modo chiaro e distinto che il contenuto è stato creato o manipolato artificialmente [AI ACT / Premessa 134].

3. Sistemi di IA ad Alto Rischio

I fornitori di sistemi di IA ad alto rischio dovranno rispettare requisiti specifici per garantire la conformità e la sicurezza di tali sistemi. Questo include l’istituzione di un sistema di gestione della qualità documentato e sistematico che copra vari aspetti come la conformità normativa, la gestione dei dati, la gestione dei rischi e la comunicazione con le autorità competenti [AI ACT / Articolo 17][AI ACT / Premessa 64]. Inoltre, i fornitori dovranno garantire che i loro sistemi di IA ad alto rischio siano conformi ai requisiti stabiliti nel regolamento e nella normativa di armonizzazione dell’Unione [AI ACT / Articolo 8].

4. Valutazione della Conformità

Gli organismi notificati saranno responsabili della verifica della conformità dei sistemi di IA ad alto rischio secondo le procedure di valutazione della conformità. Questi organismi dovranno evitare oneri inutili per i fornitori e tenere conto delle dimensioni del fornitore, del settore in cui opera, della sua struttura e del grado di complessità del sistema di IA [AI ACT / Articolo 34].

5. Protezione dei Dati e Non Discriminazione

Per proteggere i diritti altrui contro la discriminazione derivante dalla distorsione nei sistemi di IA, i fornitori, in casi eccezionali e nella misura strettamente necessaria, potranno trattare categorie particolari di dati personali per garantire il rilevamento e la correzione delle distorsioni nei sistemi di IA ad alto rischio [AI ACT / Premessa 70].

6. Codici di Buone Pratiche

La Commissione Europea potrà incoraggiare e agevolare l’elaborazione di codici di buone pratiche a livello dell’Unione per facilitare l’attuazione degli obblighi in materia di rilevazione ed etichettatura dei contenuti generati o manipolati artificialmente [AI ACT / Premessa 135].

7. Valutazioni Periodiche

La Commissione Europea effettuerà valutazioni periodiche riguardo all’uso dei sistemi di IA, le modifiche da apportare, la supervisione e governance, le risorse necessarie, le sanzioni, l’ufficio per l’IA, lo sviluppo di prodotti normativi, i codici di condotta, e la valutazione dell’impatto e dell’efficacia dei sistemi di IA [AI ACT / Articolo 112].

8. Tempistiche di Applicazione

Il regolamento stabilisce diverse scadenze per l’applicazione di specifiche sezioni. Ad esempio, i divieti e le disposizioni generali del regolamento si applicheranno sei mesi dopo l’entrata in vigore, mentre gli obblighi per i fornitori di modelli di IA per finalità generali si applicheranno 12 mesi dopo l’entrata in vigore [AI ACT / Premessa 179][AI ACT / Articolo 113].

9. Misure di Attuazione

L’ufficio per l’IA sarà responsabile di monitorare l’attuazione e il rispetto degli obblighi dei fornitori di modelli di IA per finalità generali. Questo include la possibilità di rivolgersi a esperti indipendenti per effettuare valutazioni e adottare misure adeguate per mitigare i rischi sistemici individuati [AI ACT / Premessa 164].

10. Requisiti Tecnici e Norme di Prova

La Commissione Europea adotterà specifiche tecniche e norme di prova per i sistemi di IA che sono componenti di sicurezza, tenendo conto dei requisiti stabiliti nel regolamento [AI ACT / Articolo 102][AI ACT / Articolo 105][AI ACT / Articolo 106][AI ACT / Articolo 108][AI ACT / Articolo 109][AI ACT / Articolo 104][AI ACT / Articolo 103][AI ACT / Articolo 107].

Quali sono le sanzioni previste nella prima fase di attuazione per le aziende che non rispetteranno le norme contenute nell’AI Act?

Nella prima fase di attuazione dell’AI Act le sanzioni per le aziende che non rispettano le norme sono significative.

Le violazioni del divieto delle pratiche di IA di cui all’articolo 5 possono comportare sanzioni amministrative pecuniarie fino a 35 milioni di euro o fino al 7% del fatturato mondiale totale annuo dell’esercizio precedente, se superiore [AI ACT / Articolo 99].

La fornitura di informazioni inesatte, incomplete o fuorvianti può essere sanzionata fino a 7,5 milioni di euro o fino all’1% del fatturato mondiale totale annuo dell’esercizio precedente, se superiore [AI ACT / Articolo 99].

Per le PMI, le sanzioni sono proporzionate e possono essere inferiori [AI ACT / Articolo 99]. Le sanzioni devono essere effettive, proporzionate e dissuasive [AI ACT / Articolo 101].